Il pericolo della diffusione a tappeto dell’AI è un appiattimento dei contenuti, per via della standardizzazione dell’output. Ma, al pari di qualsiasi strumento, un uso corretto e creativo del mezzo dà vita a risultati unici e spettacolari. Parola di Riccardo Franco-Loiri a.k.a. Akasha, visual artist e performer torinese per cui «arte e scienza sono sempre stati strumenti per indagare il mondo». I suoi lavori spaziano dal videomapping architetturale alle performance immersive e installazioni audiovisive. Dal 2018, assieme allo studio High Files di cui è fondatore, si è specializzato in visual design per show musicali e teatrali. Tra le sue collaborazioni più importanti spiccano i palchi per i Subsonica, per Lazza, per Capo Plaza e per Angelina Mango.

Riccardo Franco-Loiri approfondirà queste tematiche nel talk By Trial and Error, parte di Lumen, l’evento di Atmosfera Mag e A.A.G. Stucchi organizzato in occasione del Fuorisalone 2025 dedicato alla luce e alle sue interazioni con l’intelligenza artificiale, il design e la socialità. L’incontro si terrà il 10 aprile, dalle 14:30 alle 15:30. Le registrazioni sono ora aperte.

In questo momento c’è un dibattito aperto sull’utilizzo delle nuove tecnologie in campo artistico, dall’autotune nella musica all’AI generativa nell’ambito figurativo. Come si è evoluto il concetto di creatività e perché gli strumenti legati all’AI sono un potente mezzo e un supporto per chi li sfrutta?

«Il clima da nuova rivoluzione industriale che ha accompagnato l’ultima ondata di avanguardie nell’intelligenza artificiale (quella degli LLM come GPT-4 e dei modelli di diffusione per l’immagine, per intenderci) è il prodotto di un ultra-accelerazionismo che non si interroga più sulla direzione intrapresa, ma solo sulla rapidità con cui emergono nuove scoperte. Da utilizzatore, in parte entusiasta e in parte critico, di numerosi modelli e sistemi basati su AI, mi trovo immerso in un flusso incessante di innovazioni, dove seguire gli ultimi aggiornamenti di una pagina GitHub o testare le beta di un modello ancora inedito sembra dettare le tendenze estetiche stesse. Questo rappresenta un problema enorme. La standardizzazione dell’output è un pericolo concreto quando si parla di AI generativa e ritengo sia dovuto a molteplici fattori: la possibilità di creare animazioni complesse accessibile a tutti, senza più il filtro della conoscenza tecnica, ora ridotta alla semplice scrittura di un prompt efficace, unita all’appiattimento degli stili verso trend dominanti che vengono diffusi sui social, e infine la limitazione imposta dai bias insiti nei sistemi di intelligenza artificiale.

Per bias, in questo contesto, intendiamo la tendenza degli algoritmi a produrre risultati distorti a causa di dati di addestramento sbilanciati o scelte progettuali. Per fare un esempio concreto: se un anno fa avessi chiesto a un modello di generare un’immagine di una “persona bella”, probabilmente avrebbe prodotto il ritratto di una ragazza giovane, bianca e conforme ai canoni estetici occidentali (o orientali, a seconda della provenienza del modello). Al contrario, chiedendo la rappresentazione di una “persona brutta”, l’output avrebbe spesso raffigurato un uomo anziano e mulatto. Questo non solo solleva questioni sociali, ma condiziona anche la creatività stessa: i dataset, ovvero le basi di dati su cui vengono addestrati questi strumenti, riflettono determinate culture, valori e prospettive, imponendo di fatto un filtro alla generazione di immagini. Proprio in questi bias, nel territorio sfocato della “uncanny valley” dell’AI, possono nascere spunti straordinari. Il potenziale creativo dell’intelligenza artificiale mi ha affascinato fin dal primo giorno in cui ho sperimentato un sistema basato su GAN, sette anni fa: vedere apparire su uno schermo volti “veri”, con tutte le caratteristiche tipiche di un essere umano, semplicemente digitando la parola “human”, mi lasciò senza parole. Quelle figure sembravano autentiche proprio grazie alle loro imperfezioni: un naso leggermente adunco, un occhio più socchiuso dell’altro, un dente scheggiato, una ruga sulla fronte. Questi stessi dettagli, che la società tende a non valorizzare, mi affascinavano ancor di più una volta generati artificialmente.

Oggi i modelli di AI sono progrediti enormemente, ma hanno anche sacrificato parte della loro componente “realistica” in favore di un’estetica “iperrealistica”, dove ogni difetto viene eliminato e i tratti vengono esaltati al massimo. Tuttavia, proprio nella zona grigia del bias si trova anche l’errore, frutto di un’interpretazione errata o di una sovrapposizione imprevista, e da qui può emergere qualcosa di veramente innovativo. Inoltre, un’altra componente di indagine per me fondamentale nel campo dell’AI è l’ibridazione. I primi esperimenti con le GAN erano basati proprio sul “breeding” di immagini: ogni figura veniva associata a determinate parole chiave e si poteva miscelare immagini e parole chiave geneando una sorta di albero di discendenze, consentendo di combinare elementi diversi per ottenere risultati inediti. Ancora oggi, questo è uno dei miei principali campi di ricerca con l’AI: esplorare la possibilità di fondere mondi apparentemente distanti per creare nuove connessioni visive e concettuali, superando limiti fisici e computazionali. Questi sono alcuni dei temi che approfondirò durante il mio intervento a By trial and error in programma nel palinsesto di talk di Lumen, il 10 aprile dalle 14.30 alle 15.00».

Tra i tuoi lavori “più pop” ci sono i visual per i concerti di artisti come Subsonica, Angelina Mango, Lazza. Come nascono?

«La nascita di questi progetti avviene tra mani amiche, tra le scrivanie di un laboratorio nella Torino Nord che condivido con il mio studio High Files e l’associazione Sintetica, di cui facciamo tutti parte. High Files è la mia realtà creativa e una seconda famiglia: insieme a Tommaso Rinaldi, con cui ho fondato il progetto nel 2018, abbiamo attraversato ogni mare e tempesta, tra flussi di dati, pixel, luci negli occhi e computer bollenti.

Abbiamo sempre avuto un legame profondo con la musica, collaborando con band, artisti e festival di tutto il mondo. Negli ultimi anni ci siamo concentrati su progetti per tour di grande portata, saltando da un genere all’altro con entusiasmo. Sebbene sia un ambiente in costante movimento, amiamo lavorare con i palchi, la musica e i team che si formano attorno a queste produzioni. In particolare, abbiamo instaurato una solida collaborazione con studi di lighting design italiani come Blearred e Studio Neuma.

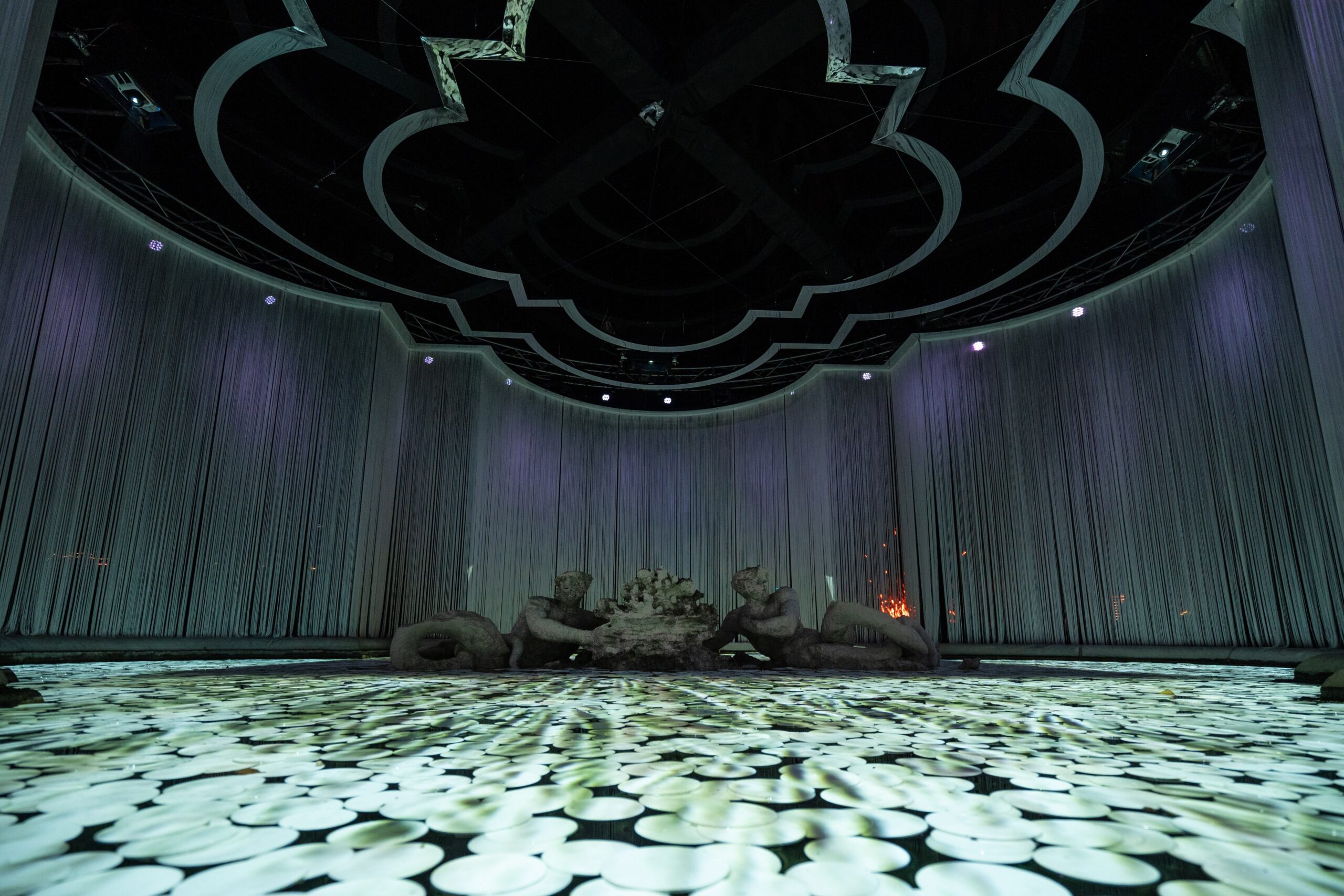

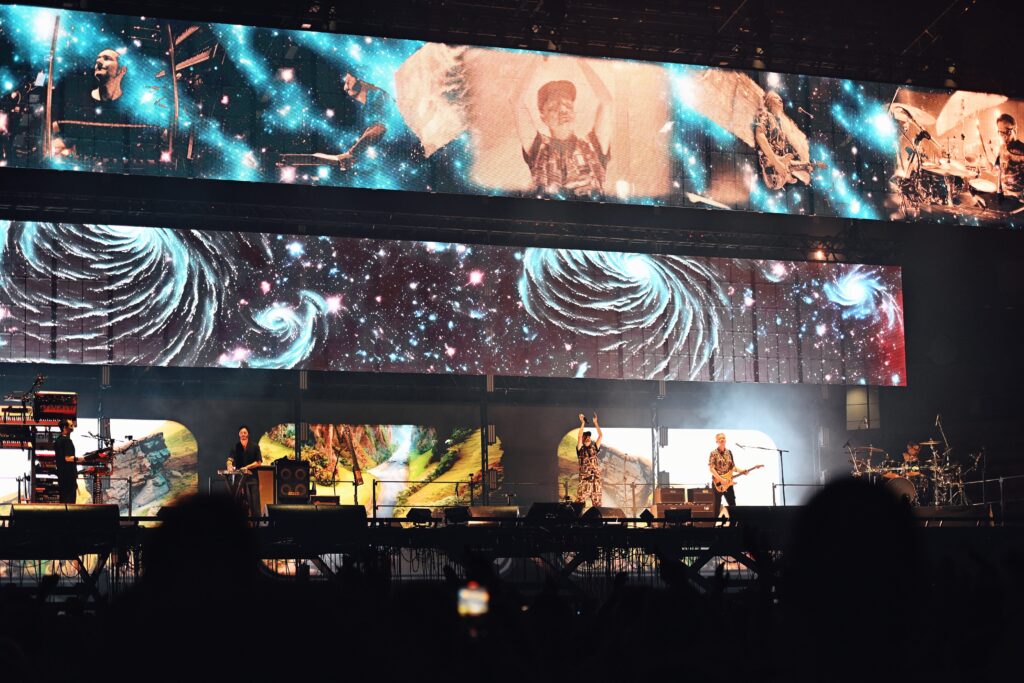

Con loro abbiamo realizzato alcuni degli show più seguiti degli ultimi due anni in Italia, cercando sempre di portare sperimentazione e innovazione tecnologica. Una delle parti più stimolanti di queste collaborazioni è la possibilità di contaminarsi reciprocamente nelle scelte creative, arrivando a risultati sempre freschi e mai scontati. Sebbene l’artista sia il fulcro dello spettacolo, il palco assume oggi un ruolo sempre più centrale, non solo come supporto visivo ma come vero e proprio universo narrativo. Lo show di Lazza, progettato da Blearred, rispecchiava perfettamente la sua estetica e ci è stata concessa totale libertà creativa dopo un confronto iniziale con il team. Una condizione tutt’altro che scontata, considerando le esigenze di molteplici figure coinvolte. Abbiamo conosciuto i ragazzi di Blearred durante il tour Realtà Aumentata dei Subsonica nel 2024. Da subito abbiamo percepito una forte sintonia e abbiamo osato tantissimo, costruendo uno show dinamico basato sul movimento continuo di tre LED wall trasparenti larghi 20 metri e cinque pedane lifter indipendenti che sollevavano i membri della band. Il linguaggio visivo era strettamente intrecciato a questi movimenti, generando illusioni ottiche, rivelazioni e punti di focus. Essendo io e Tommaso profondamente legati alla band, abbiamo voluto reinterpretare i loro concetti in chiave contemporanea, restituendo una visione fedele alla loro poetica. Il risultato ci ha resi estremamente orgogliosi, soprattutto nei confronti di un gruppo a cui dobbiamo molto.

Quando sviluppiamo la produzione di un tour, ci assicuriamo che lo show sia un discorso unitario, con un’identità visiva distintiva per ogni progetto. Gli artisti devono sentirsi rappresentati e valorizzati dalle immagini che li accompagnano. Il nostro lavoro si basa sulla dinamica delle immagini: utilizziamo gli schermi come fonti luminose vive e pulsanti, prediligiamo montaggi ritmici e incisivi e cerchiamo di estrarre quante più informazioni sonore possibile da ogni brano, aggiungendo livelli di reattività e dinamismo. Sperimentiamo costantemente con un’ampia gamma di software e tecniche, dal 3D alla generazione algoritmica in tempo reale, dall’AI alla motion graphic tradizionale, creando per ogni performance un modus operandi specifico. Questo approccio mantiene il nostro studio un ambiente stimolante, ricco di confronto e ricerca, dove ogni progetto è un’occasione per testare nuove soluzioni e sviluppare metodi sempre più personali.

Hai anche realizzato un video con AI generativa, il cortometraggio che accompagna la canzone Turnà di Liberato. Come è nato e come è stata sfruttata la tecnologia per arrivare a un risultano non raggiungibile con altri mezzi?

«A novembre io e Gabriele Ottino di SPIME.IM siamo stati contattati da Francesco Lettieri, regista e mente visiva dietro il progetto di LIBERATO, che ci proponeva di realizzare il videoclip del singolo dell’album di ritorno dell’artista partenopeo. Francesco aveva visto Hint, un video prodotto da me e Gabriele per l’ultimo album Grey Line di SPIME.IM. Hint è stata la nostra prima collaborazione, un viaggio distopico in piano sequenza, un hypertrip che alternava scenari in rovina a grottesche ville di milionari, immaginando un futuro in cui il divario sociale si ampliava sempre di più. Per realizzarlo, abbiamo sperimentato molto con l’AI, sviluppando un workflow personale.

Dopo quel video, io e Gabriele abbiamo iniziato una sperimentazione insieme nel campo dell’AI e abbiamo lavorato con produzioni di show e videoclip più disparate (fra cui gli show di Cosmo, Nayt, Baby Gang e il video Universo dei Subsonica). Francesco ci chiese sostanzialmente di ricreare un’esperienza simile a Hint per Turnà. Proprio in quei giorni, io e Gabriele siamo stati invitati a partecipare all’alpha test di Sora, il nuovo modello di sintesi video di OpenAI. Abbiamo proposto a LIBERATO e Francesco di utilizzarlo per il progetto e, dopo aver ottenuto l’approvazione dal team di OpenAI, ci siamo immersi nel lavoro con uno strumento ancora inesplorato, dai risultati tanto sorprendenti quanto imprevedibili.

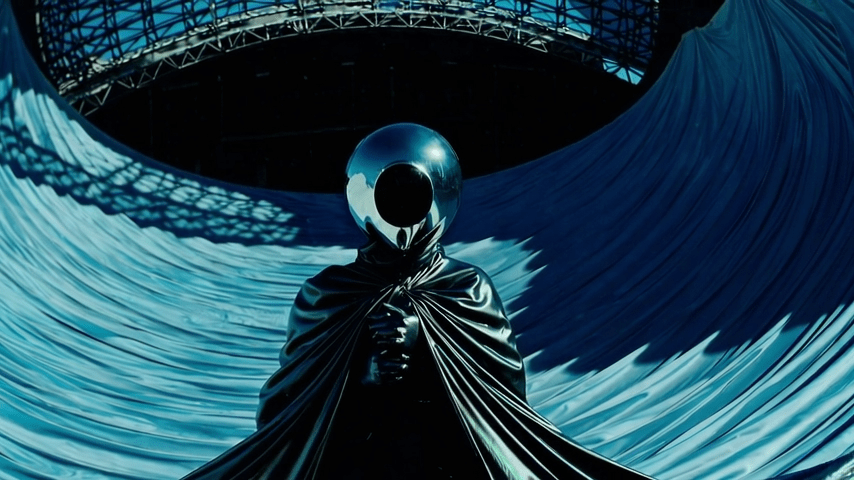

Ci siamo cimentati in un’impresa complessa ma incredibilmente stimolante: fondere riprese reali, girate a Napoli con un team di operatori, con sequenze generate dall’AI, creando una narrazione fluida quasi senza stacchi, in una sorta di lungo piano sequenza. Il video è un omaggio a Napoli, alla sua cultura e alla sua follia intrinseca: maschere e simboli della smorfia si intrecciano ai vicoli dei Quartieri Spagnoli, rivelando tesori nascosti mentre sorvoliamo lo stadio Maradona accompagnati da un misterioso essere incappucciato.

Alcune delle sequenze più riuscite sono nate proprio dagli errori, da processi ripetuti in modo ricorsivo per ottenere risultati inaspettati. Abbiamo manipolato i prompt come in un cut-up alla Burroughs, sfruttando la modalità storyboard per mescolare immagini generate, descrizioni testuali e tagli video. Da questi esperimenti nascevano segmenti che poi sottoponevano a nuove elaborazioni, in un processo quasi alchemico, esplorando i limiti del mezzo. L’obiettivo era restituire una visione caleidoscopica e sfaccettata di Napoli, un viaggio che in soli tre minuti potesse catturare le suggestioni e l’energia magnetica che noi, da “forestieri”, abbiamo percepito nella città. Il video è uscito il primo gennaio, ponendosi anche come primo videoclip europeo generato con la tecnologia di Sora. Vedere la reazione festosa del pubblico e dell’intero team di LIBERATO è stato il miglior modo possibile per iniziare l’anno e speriamo di continuarlo al meglio».